Quando você vê o mítico ouroboros, é perfeitamente lógico pensar “bem, isso não vai durar”. Um símbolo potente, engolindo sua própria cauda — mas difícil na prática. Pode ser o caso da IA também, que, de acordo com um novo estudo, pode estar em risco de “colapso do modelo” após algumas rodadas de treinamento em dados que ela mesma gerou.

Em um artigo publicado na Nature, pesquisadores britânicos e canadenses liderados por Ilia Shumailov em Oxford mostram que os modelos de aprendizado de máquina atuais são fundamentalmente vulneráveis a uma síndrome que eles chamam de “colapso do modelo”. Como eles escrevem na introdução do artigo:

Descobrimos que aprender indiscriminadamente a partir de dados produzidos por outros modelos causa “colapso do modelo” — um processo degenerativo pelo qual, ao longo do tempo, os modelos esquecem a verdadeira distribuição de dados subjacente…

Como isso acontece e por quê? O processo é, na verdade, bem fácil de entender.

Os modelos de IA são sistemas de correspondência de padrões no fundo: eles aprendem padrões em seus dados de treinamento e, em seguida, correspondem prompts a esses padrões, preenchendo os próximos pontos mais prováveis na linha. Quer você pergunte “qual é uma boa receita de snickerdoodle?” ou “liste os presidentes dos EUA em ordem de idade na posse”, o modelo está basicamente retornando a continuação mais provável dessa série de palavras. (É diferente para geradores de imagens, mas semelhante em muitos aspectos.)

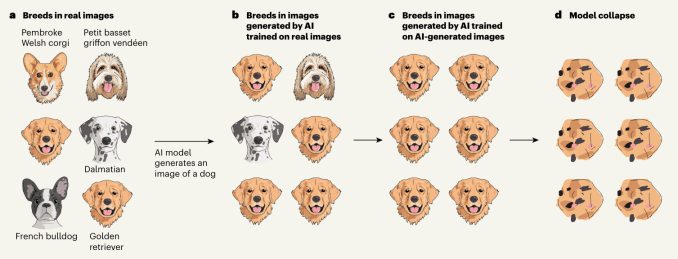

Mas a questão é que os modelos gravitam em direção à saída mais comum. Ele não lhe dará uma receita controversa de snickerdoodle, mas a mais popular e comum. E se você pedir a um gerador de imagens para fazer uma imagem de um cachorro, ele não lhe dará uma raça rara da qual ele viu apenas duas imagens em seus dados de treinamento; você provavelmente obterá um golden retriever ou um labrador.

Agora, combine essas duas coisas com o fato de que a web está sendo invadida por conteúdo gerado por IA, e que novos modelos de IA provavelmente estarão ingerindo e treinando esse conteúdo. Isso significa que eles verão uma muito de dourados!

E uma vez que eles treinaram nessa proliferação de goldens (ou blogspam mediano, ou rostos falsos, ou músicas geradas), essa é sua nova verdade fundamental. Eles vão pensar que 90% dos cães são realmente goldens e, portanto, quando solicitados a gerar um cão, eles vão aumentar ainda mais a proporção de goldens — até que basicamente tenham perdido a noção do que os cães são.

Esta maravilhosa ilustração do artigo de comentário da Nature mostra o processo visualmente:

Algo semelhante acontece com modelos de linguagem e outros que, essencialmente, favorecem os dados mais comuns em seu conjunto de treinamento para respostas — o que, para ser claro, geralmente é a coisa certa a fazer. Não é realmente um problema até que se encontre com o oceano de iscas que é a web pública agora.

Basicamente, se os modelos continuarem comendo os dados uns dos outros, talvez sem nem saber, eles ficarão progressivamente mais estranhos e burros até entrarem em colapso. Os pesquisadores fornecem vários exemplos e métodos de mitigação, mas eles chegam a ponto de chamar o colapso do modelo de “inevitável”, pelo menos em teoria.

Embora isso possa não acontecer como os experimentos que eles fizeram mostram, a possibilidade deve assustar qualquer um no espaço da IA. A diversidade e a profundidade dos dados de treinamento são cada vez mais consideradas o fator mais importante na qualidade de um modelo. Se você ficar sem dados, mas gerar mais riscos de colapso do modelo, isso limita fundamentalmente a IA de hoje? Se isso começar a acontecer, como saberemos? E há algo que podemos fazer para prevenir ou mitigar o problema?

A resposta para a última pergunta é provavelmente sim, embora isso não deva aliviar nossas preocupações.

Benchmarks qualitativos e quantitativos de origem e variedade de dados ajudariam, mas estamos longe de padronizá-los. Marcas d’água de dados gerados por IA ajudariam outras IAs a evitá-los, mas até agora ninguém encontrou uma maneira adequada de marcar imagens dessa forma (bem… Eu fiz).

Na verdade, as empresas podem ser desincentivadas a compartilhar esse tipo de informação e, em vez disso, acumular todos os dados originais e gerados por humanos hipervaliosos que puderem, retendo o que Shumailov et al. chamam de sua “vantagem de pioneiro”.

[Model collapse] deve ser levado a sério se quisermos sustentar os benefícios do treinamento a partir de dados em larga escala extraídos da web. De fato, o valor dos dados coletados sobre interações humanas genuínas com sistemas será cada vez mais valioso na presença de conteúdo gerado por LLM em dados coletados da Internet.

… pode se tornar cada vez mais difícil treinar versões mais recentes de LLMs sem acesso a dados que foram coletados da Internet antes da adoção em massa da tecnologia ou acesso direto a dados gerados por humanos em escala.

Adicione isso à pilha de desafios potencialmente catastróficos para modelos de IA — e argumentos contra os métodos atuais que produzem a superinteligência de amanhã.